『日経研月報』特集より

AI×半導体で世界はどう変わるのか ~次の10年を読む~

2025年12-2026年1月号

(本稿は、2025年8月6日に開催された講演会の要旨を事務局にて取りまとめたものです。)

1. はじめに

2. 大規模言語モデルを中心としたAIの現状

3. AIはどのように作られるのか

4. AIの需要

5. AI半導体・データセンター

6. PFNの取組み

1. はじめに

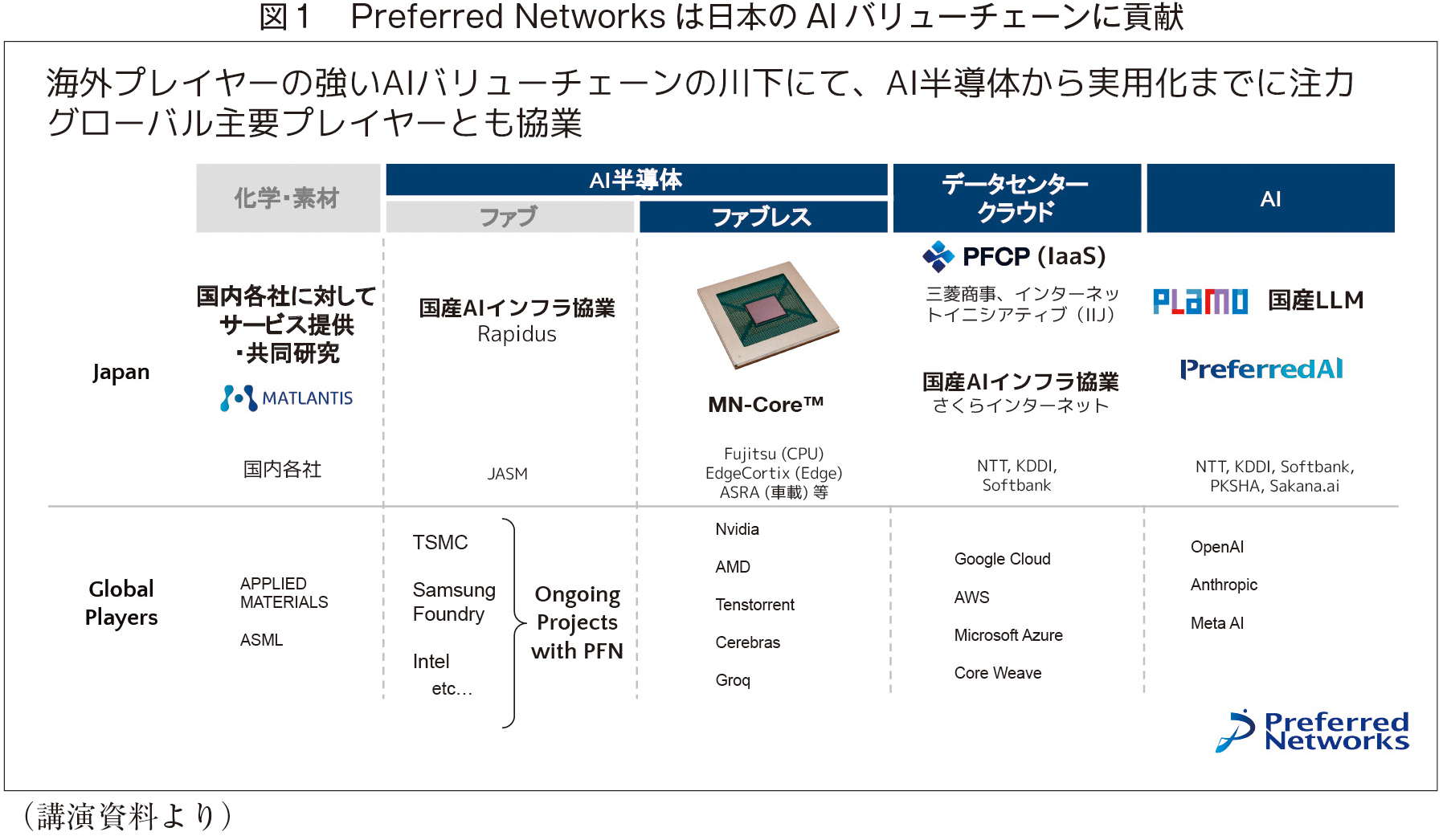

株式会社Preferred Networks(以下、PFN社)は、深層学習技術の実用化を目的として、2014年3月に設立された会社です。当社はAI半導体、計算基盤、生成AI基盤モデル(PLaMo)、AIソリューション・製品など、AI技術のバリューチェーンを垂直統合し、ソフトウェアとハードウエアを高度に融合することで、競争力の高い技術開発と産業応用を進めています(図1)。当社が提供する「Matlantis」は、原子スケールで材料の挙動を再現し、大規模な材料探索を可能にする汎用原子レベルシミュレータで、半導体からサービスまですべて自社で賄い、PFN社の技術スタック上で稼働させることができます。素材科学研究向けのSaaSとして、全世界100以上の企業・研究機関で利用されています。また、当社ではAI半導体の自社開発を強化するため大規模な投資を行い、複数ラインで新しい半導体の設計を進めています。現在、OpenAI社、Anthropic社、Core Weave社等、AIバリューチェーンを構成するグローバルプレイヤーの多くは、米国NVIDIA社が設計する半導体製品を約8~9割使用しています。その半導体の製造は、主に台湾TSMCや韓国Samsungが担っています。

かつて最先端の半導体製品製造は日本のお家芸でしたが、国内の最先端研究所や工場が減ったため技術レベルが向上せず、主導的地位を失った結果、いわゆるデジタル赤字が拡大しています。日本の半導体やデジタルインフラなどの事業もトーンダウンしていましたが、足元で経産省が中心となり、北海道のRapidusや熊本のTSMC誘致など、国内でのプロジェクトがようやく進み始めています。このような状況下において、当社は日本のAIバリューチェーンの空白部分を埋めるべく、貢献していきたいと考えています。

2. 大規模言語モデルを中心としたAIの現状

生成AIは、生成対象を決め、条件(コンディション)を設定すると、その条件に応じたさまざまなものを作ってくれる“魔法の箱”のような技術です。生成AIには、画像生成や大規模言語モデル:Large Language Model(以下、LLM)など、さまざまな種類があります。ChatGPTもLLMの一種です。こうした一見全く異なるタスクでも、条件や生成対象を切り替えることで、幅広い生成が可能です。例えば、生成AIでタンパク質を設計したり、ロボットを制御したりするブレイクスルーも起きています。

生成AIは現在、技術的にもビジネス的にも重要な分野となり、世界中で研究が進んでいます。その進化は予測可能な形で、着実に、なめらかに進んでおり、右肩上がりの成長を示しています。AIはすでに多くの分野で人間を超える能力を発揮しており、例えば東大入試や医師国家試験、会計士試験でも合格点に達するレベルに到達しています。ただし、これらの試験に合格できる能力があっても、医師や会計士の仕事を完全に代替できるわけではありません。それでも、AIの性能が向上する中で従来のテストではその能力を十分に測ることができなくなり、2025年1月には「Humanity’s Last Exam」と呼ばれる超難問テストが新たに作成されました。このテストでは、古代パルミラ文字の翻訳といった難解な問題が出題されましたが、生成AIは21%の正答率を達成しました。一部の分野では、すでに専門家を超える成果を上げています。

このような進化が可能になった背景には、計算機の速度が飛躍的に向上したことと、それに伴う計算資源の向上と学習データの増加があります。さらに、この10年で特に画像生成が驚異的に進化しました。2013年頃は簡単な数字画像の生成さえ困難でしたが、計算資源や学習データが数百倍に増加したことで、現在では複雑な画像(複数の人、光学現象、姿勢など)を誰でも生成できるようになりました。

また、生成AIの開発や運用を担う企業や研究機関の努力により、生成AIのコストも急速に低下しています。同じ性能を提供するコストは、1年あたり約1000分の1のペースで下がり続けており、今年1万円かかるものが来年には10円になるといった世界が現実となっています。

3. AIはどのように作られるのか

AIの基盤となる理論は、コンピューター理論を打ち立てたクロード・シャノンが1948年に提唱した「言語モデル」に由来します。これは、ある文章があったとき、次に出現しそうな単語を予測する仕組みです。例えば、「私は父と一緒に***」という文章の後に、「病院」?「遊ぶ」?「過ごした」?など、どんな単語が出てくるのかを予測します。この予測が当たるモデルが構築できれば、人のように自然な会話が可能になるのではないかと考えられてきました。

AIを作るためには、良質な練習問題を用意し、それを通じてモデルを鍛えていくことが重要です。そのためには、正解がタダで、いくらでも手に入る「教師あり学習」が必要となります。次の単語を予測するためには、文章やその背後の情報を理解する必要があるため、現在のLLMは膨大な文章データを学習します。先述の、「私は父と一緒に***へ行き、相談した」という文章で、「***」に「病院」が入ると予測できるようになるには、前後の文脈を理解している必要があります。このようにLLMは、次の単語を予測するために文章や概念を理解する必要に駆られ、結果として言語やその背後の概念を理解することになりました。

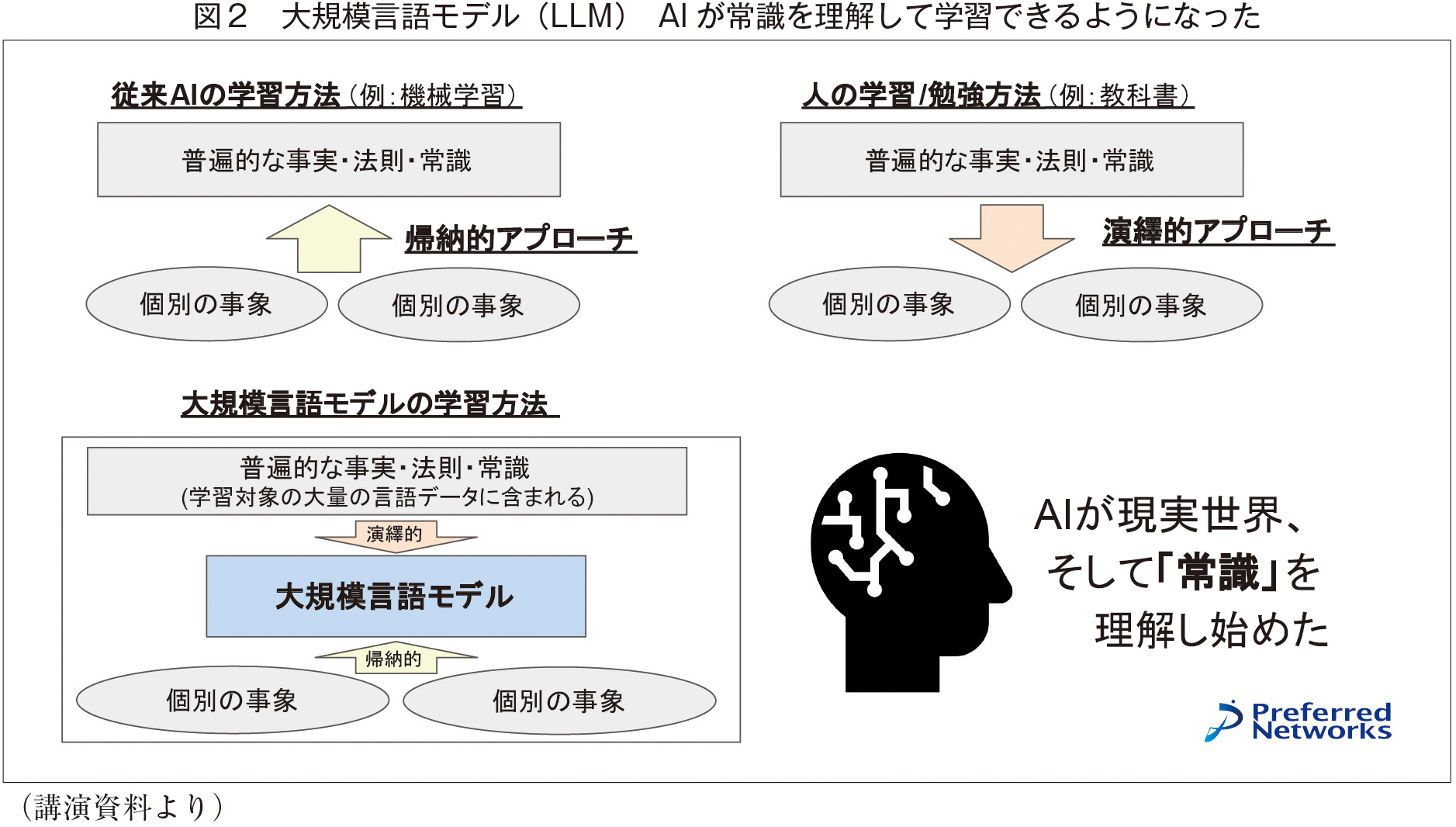

さらに、AIは常識を理解できるようになってきました。従来のAIの学習方法(機械学習)は、個別の事象から普遍的な事実や法則を学ぶ「帰納的アプローチ」でした。一方、人間は教科書などで普遍的な知識を学んでから個別の事象を学ぶ「演繹的アプローチ」です。現在のLLMは、この両方を組み合わせた学習が可能です。例えば自動運転システムでは、従来のAIが学習データにない状況(道路に人が倒れているなど)に対応できなかったのに対し、LLMを活用したシステムでは、常識を基に「危険だから避けよう」と判断できるようになります(図2)。

AIの性能向上において重要な転機となったのは、2020年頃に発見された「スケーリング則」です。これは、学習データ量、モデルサイズ、学習時の投入計算量を大規模化することで、論理思考や質問応答、抽象的な予測性能や後続タスク性能が改善されるという法則です。しかし、2024年頃にはスケーリング則の限界が見えてきました。OpenAI社創設者のイリア・サツケバー氏は、「インターネットは一つしかないので、データはもう増えない。化石燃料のようなものだ」と、スケーリング則による改善は難しいことを断言しています。

一方、別方式による改善が急速に進んでいます。まずは学習データの品質改善です。学習データの品質が良ければ、少ない投入計算量で高い性能が得られます。AI自身が、どのデータが学習に適しているかをフィルタリングすることで、AI自身が良質な練習問題を作り、理解度を上げていくことができるようになりました。また、数学やプログラミングなど検証可能な報酬を基にした強化学習を使った推論能力の改善も、急速に進んでいます。これにより、難しい数学命題や複雑なプログラムを解けるように学習されたモデルは、その問題以外にも汎化し広い問題を解く能力を改善しています。

4. AIの需要

近年、AIへの投資が進み、利用も爆発的に増えています。現在のLLM需要の半分以上はソフトウェア開発支援です。特に金融業や製造業では、新しいソフトウェアの開発や既存システムのメンテナンスに多大なリソースを費やしており、AIがその負担を軽減しています。現在のAIは、1時間あたり8ドルで、新卒と同じレベルでコードを読み、書き、テストを行い、コミットできます。このコストパフォーマンスにより、多くのエンジニアがAIを積極的に活用し始めています。

世界のプログラマは約2,600万人(うち米国450万人、インド340万人、日本144万人)いますが、仮に全員がAIを8時間/日、25日/月利用すると、年間75兆円規模の市場が生まれる計算になります。実際、Microsoft社、Google社、Meta社においても、既に多くのコードがAIによって生成されており、AI生成コードの比率は全体の2~5割に達しています。

産業領域では、自動運転技術においてもブレイクスルーが起きています。例えば、Wayve社の自動運転向け世界モデルは、運転時に見えるであろう各カメラからの画像を、状況や国ごとに異なるシーン(イギリスバージョン、ドイツバージョン、雨天時バージョン等)で指定することで、その場、その時に見える画像を生成AIが即時に作り出します。この技術により予めシミュレーションができ、世界中に一気に展開できるため低コスト開発が可能となります。

今後はAIの需要はさらに広がると予想されます。特に注目されるのが「フィジカルAI」です。ロボット向けのAIスタートアップが米国や中国で多数登場し、LLMがそのまま活用されています。また、画像生成、動画生成、音声生成等も急成長しており、OpenAI社はこれらの市場が1兆円市場に達すると見込んでいます。

5. AI半導体・データセンター

AIのさらなる発展には、膨大な計算資源とデータセンターが必要となってきます。AIを動かすための半導体も急増しており、日本でも半導体製造装置産業が伸びています。特に、AIを「作る」(学習)のための計算量は、圧倒的に増えています。1952年からの「AIの最先端モデルを作るために必要な計算量」の対数グラフを見ると、2010年以降、5.5ヶ月ごとに2倍、1年で4.6倍のペースで増加しています。

AI半導体(チップ)は、超巨大データセンターでの利用を前提に設計されており、速く試行錯誤できることが求められます。データセンターでは、大量のチップが連携し1つのAIモデルを作るため、ネットワークや電源の効率性が重要です。これらのデータセンターは「AIスパコン」と呼ばれ、今後計画されているデータセンターでは数ギガワット規模の電力を消費します。1ギガワットは大型原発1基分に相当し、約100万人分の電力消費量に匹敵します。これらの施設は、グリーンエネルギーでの運用を目指しています。

AI推論の需要は、2024年後半から爆発的に増加しており、前年比で80倍に伸びています。使われる多くがソフトウェア開発です。例えば、Google社では、2025年5月時点で480兆トークンを使っていたのですが、2ヶ月後には980兆トークンと約2倍に増加しました。トークンとは、AIが文章や画像、プログラムを理解・生成する際の最小単位です。例えば、ユーザーが「半年後に日米貿易におけるリスクを教えてください」と質問すると、内部では16入力トークンを処理します。その質問にAIモデルが回答するには、600出力トークンを消費します。トークンは「知識の通貨」であって、換金もできます。すなわち、AIデータセンターはトークンを生み出す工場とも言えます。

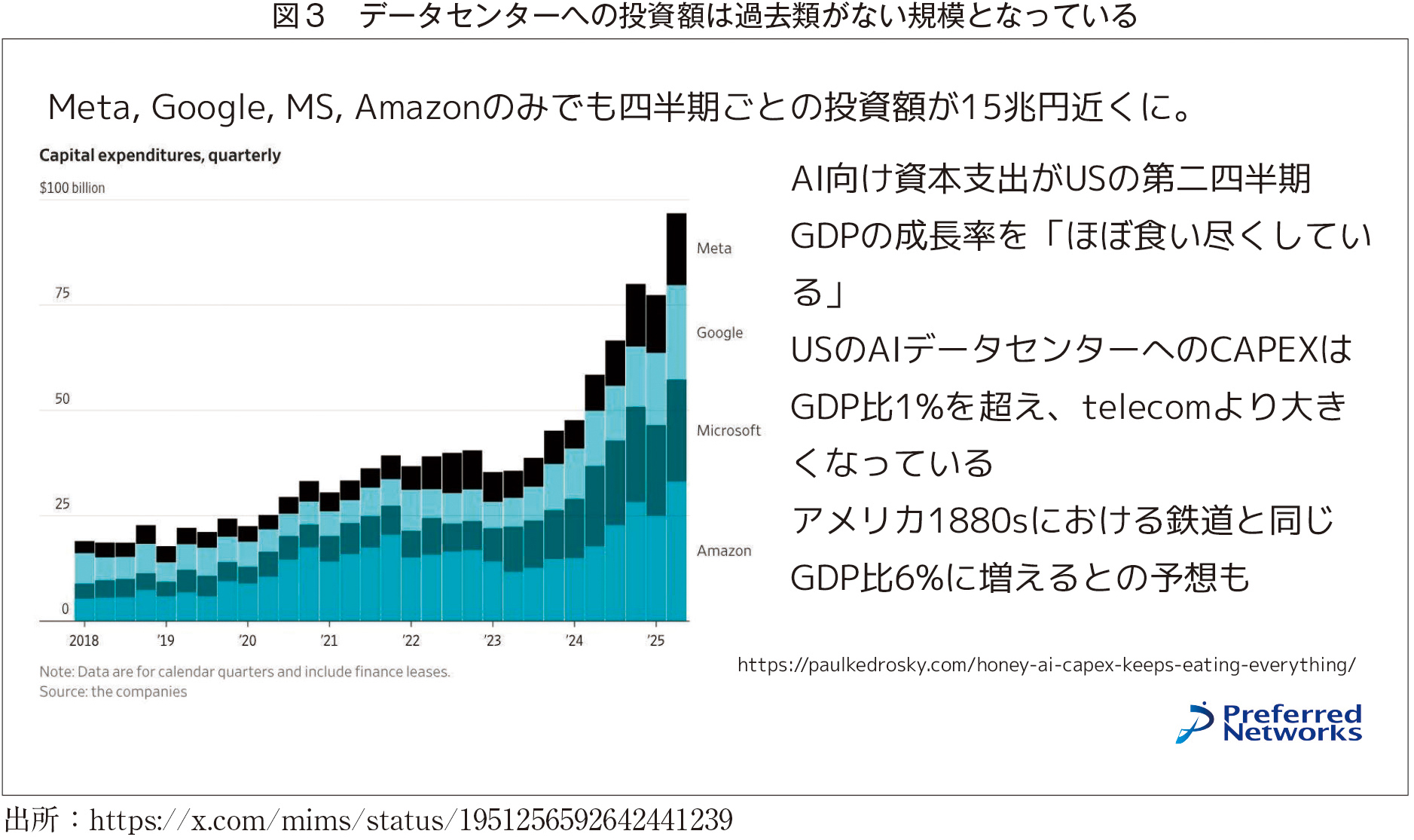

このような背景から、学習(作る、AIモデルの構築)向けや推論(使う、AIモデルの利用)向けのいずれも計算資源の需要が増えており、データセンターへの投資額は急増しています。Meta社、Google社、Microsoft社、Amazon社のみで、四半期ごとの投資額は15兆円近くに達しています。AI向け資本支出は、米国の第2四半期GDPの成長率をほぼ食い尽くす規模で、通信業を上回る水準に達しています。Meta社は、数ギガワット級のデータセンター「Prometheus」に1.5兆円(100億ドル)を投資すると発表しており、AIインフラへの投資がますます加速しています(図3)。

出所:https://x.com/mims/status/1951256592642441239

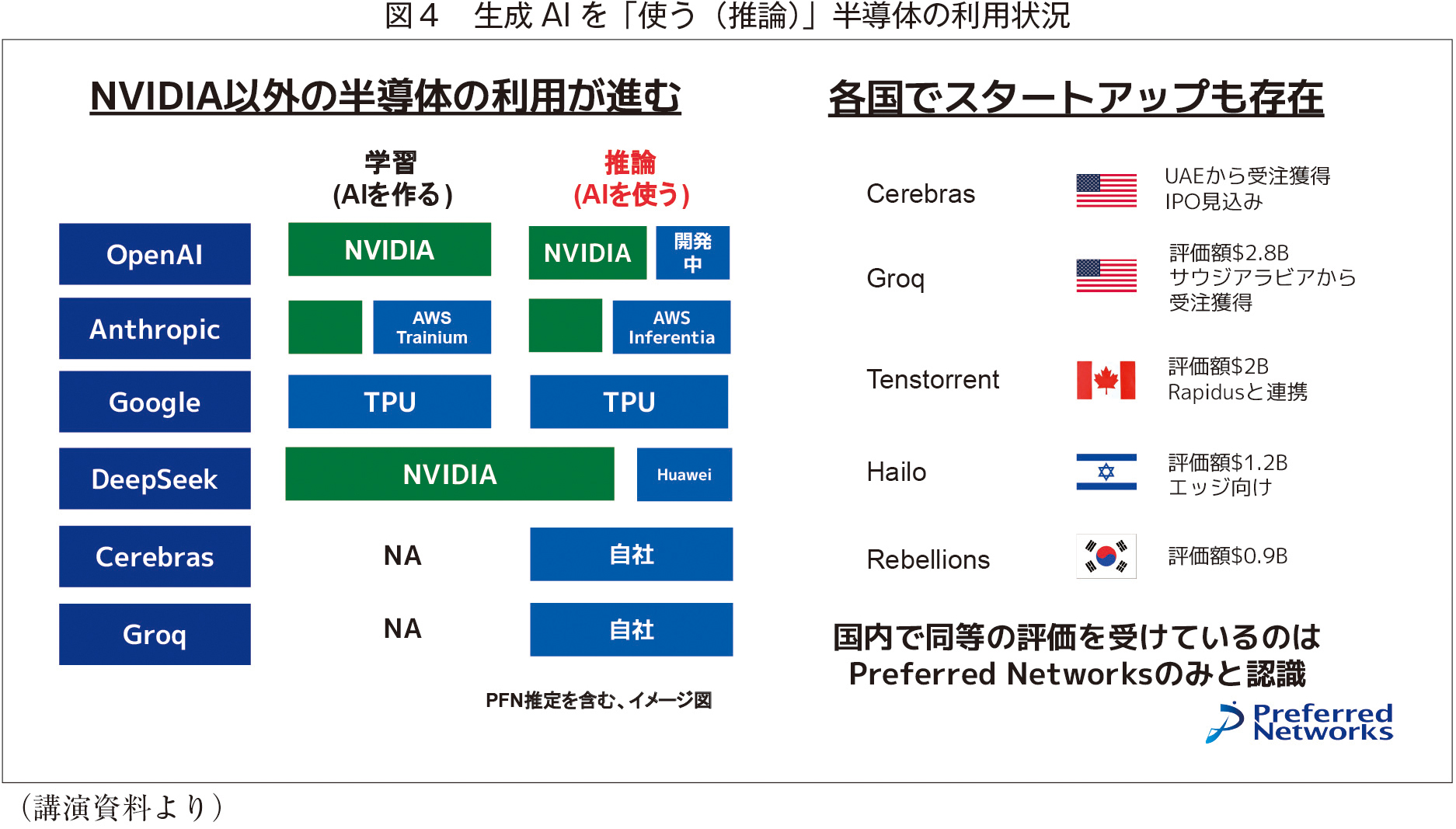

AI半導体では、NVIDIA社製の半導体が多く使われていますが、百花繚乱であり、勝負は未決です。例えば、Anthropic社はAWS社製半導体を、GoogleはTPU社製半導体を、DeepSeek等の中国企業はHuawei製半導体を採用するなど、多様な選択肢が存在しています(図4)。

学習用半導体は計算力(演算チップ)の速度が重視されるため、周辺ハードウエアの大規模エコシステムで1箇所に集中させることが重要です。一方、推論用半導体は1カ所に集める必要がなく最低数個のAI半導体でも十分に機能するため、不要なハードウエアを排除したコスト競争力が重要であり、用途に応じた最適化が進んでいます。

2035年は、AIデータセンターが電力や通信と同様のインフラになり、資本支出はGDP比5%(毎年150兆円規模)に達するという見通しもあります。AIデータセンターの進化に伴い、ソフトウェア開発支援だけでも数兆円から数十兆円の市場が形成されていますが、他の分野でも同規模の市場が新たに立ち上がると予想されています。AIの活用が進むことで、既存産業にも大きな変革がもたらされることが期待されます。

6. PFNの取組み

当社は、生成AIの推論に最適化した半導体「MN-CoreL1000」を開発し、2027年の提供を予定しています。この半導体は、低コスト、低電力での動作を重視しており、3次元積層DRAMと呼ばれる新しいテクノロジー等を用いて大容量化と高速化を安価に実現します。これにより、デスクトップ1台のマシンでも最先端モデルを高速に動かすことが可能になります。

また、当社では純国産のフルスクラッチで作るLLM「PLaMo」を提供しています。このモデルは、経産省の生成AI開発支援プロジェクトGENIACで採択されて開発されたもので、世界最高クラスの日本語モデルに位置づけられています。この特化型モデルの第一弾が「PLaMo翻訳」(翻訳タスクに特化したモデル)です。既存サービスを上回る翻訳性能を実現するとともに、低コスト・高速翻訳を可能にしています。

さらに、フィジカルAIやロボット分野にも商機を見出しています。ロボットやドローン向けに活用できるLLMを開発しており、例えばドローンでのインフラ点検時に応用できます。また、AIアバターとの面接を通じて実務スキルを評価する「Talent Scouter」も提供しています。これは、リアルタイム応答や、シナリオに基づいた会話によって採用のミスマッチ削減、評価の一貫性を支援するサービスです。その他、関連する多様な製品を展開し、幅広い分野での活用を目指しています。

〈質疑応答〉

質問A 生成AIの進化に伴い、交通分野ではどのような革新的な変化が予想されますか。

岡野原 まずは自動運転技術です。Alphabet社傘下のWaymoは、ディープラーニングの技術を用いて、環境認識を基に走行可能な自動運転システムを構築しました。世界的にも先進的で、既に実用化されています。

もう1つは、Wayve社の自動運転向け世界モデルです。これが実現すると、世界中で一気に展開可能な自動運転システムが誕生します。このアプローチは、ビジョン・ランゲージ・アクションと呼ばれるモデルを活用し、例えばLLMが直接「子どもがいるから待ちましょう」といった判断を出力し、車両を制御する仕組みです。このような制御方式の進化により、自動運転技術はこれまでとは別次元のものになるでしょう。商用車は運用体制を整えやすいため、普及はトラックやタクシーなどから始まると考えられます。

質問B プログラムをもっとシンプルするためにAIを使いたいです。生成AIは無駄の削減や書き換え、検証に対応できるのでしょうか。

岡野原 現在、生成AIはコードの修正やモダンなメンテナンスを支援する形で活用されています。例えば、人手でコードを直すときも、AIのサポートを受けることで、当初想定していた工数を削減できることが実証されています。また、既存のコードをメンテナンスしやすい形に変換したり、仕様書の不完全な部分を補完するためにAIを活用するケースも増えています。さらに、回帰テストの自動生成や既存テストの改善にもAIが役立っています。ただし、全自動化にはまだ課題があり、人手でサポートしながらという形が現実的です。一方で、生成AIは急速に進化しており、すでに多くの分野で実用レベルに達しています。1年後にはさらに進化し、より多くのタスクを効率的に処理できるようになるでしょう。

質問C 中国へのAI半導体供給を制限すべきだという意見と、制限するとかえって中国の開発力が向上するため供給すべきという意見がありますが、どのようにお考えですか。

岡野原 現在、中国は自分で強いAIアクセラレータを作る状態になっています。米国側が半導体を輸出しない方針を取った結果、HUAWEI等中国勢の技術が大きく進化しました。このことから、供給を制限することが必ずしも中国の技術力を抑える効果を持つとは限らないと考えられます。

質問D データセンターの省エネ化を含め、御社が今後注目している技術分野を教えてください。

岡野原 AIの巨大データセンターを建設する際、発熱と電力消費の増加が大きな課題となっています。特にAI半導体は高温になりやすく、水冷が必要で、その冷却プロセス自体が大きな電力消費を引き起こしています。そのため、エネルギー効率の高い冷却技術に注目しています。AI半導体の電力消費は、計算部分とメモリ部分がそれぞれ約半分を占めています。計算部分については、最先端プロセスを活用することで効率化が進んでいます。一方、メモリ部分の省エネ化は依然として課題です。特に、後工程での優れたパッケージング技術は電力効率に直結するため注目しています。さらに、光電技術にも注目していますが、半導体内部での配線や接合、設計の難易度が高いため、まだ基礎研究段階にあると考えています。これらの技術分野を注視しながら、プロジェクトを進めていきたいと考えています。

AI・デジタル化

AI・デジタル化